用电量 8 年预估飙升 100 倍: 英伟达 AI 服务器成“电老虎”

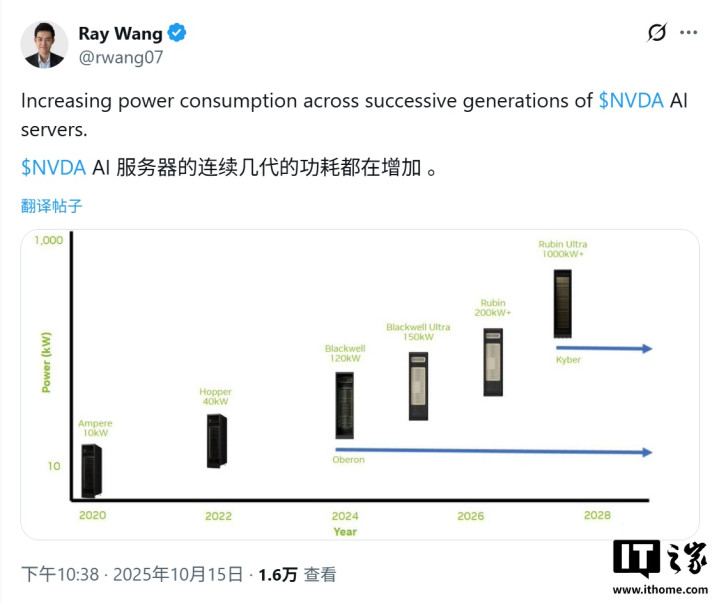

IT之家10月16日消息,行业分析师RayWang昨日(10月15日)在X平台发布推文,报道称英伟达AI服务器功耗正以惊人速度增长,从Ampere架构到未来的Kyber架构,其机架级解决方案的功耗在短短八年内将飙升100倍。

IT之家援引博文介绍,分析师指出英伟达机架功耗大幅增长的背后,存在多种驱动因素。其中,最核心的原因在于两大层面:首先是每个机架集成的GPU数量大幅增加;其次是每一代GPU自身的热设计功耗(TDP)也在不断提升。

以具体产品为例,采用Hopper架构的服务器机箱功耗约为10千瓦,而到了最新的Blackwell架构,由于集成了更多、更强的GPU,该数值已飙升至近120千瓦。英伟达为了满足行业对算力的无尽需求,在技术上持续突破,但其能耗增长速度也同样惊人。

除了硬件本身,先进的NVLink/NVSwitch互连技术、新一代机架设计以及持续高负载的运行模式,都共同导致了超大规模数据中心运营商的能耗以前所未有的速度攀升。

有趣的是,大型科技公司之间已卷入一场衡量标准为“吉瓦”(GW)的算力竞赛。例如,OpenAI和Meta等公司均计划在未来几年内新增超过10吉瓦的计算能力,这标志着AI基础设施的规模已进入新的量级。

“吉瓦级”的功耗意味着什么?据估算,一个超大规模数据中心消耗1吉瓦的电力,就足以供应约100万户美国家庭的用电需求,并且该估算尚未计入散热和电力传输等环节的额外能耗。

当这些巨型数据中心在全球各地建成后,单个设施的耗电量将相当于一个中等规模国家或美国几个大州的总和。

国际能源署(IEA)在其研究报告中预测,到2030年,仅人工智能一项就可能导致全球电力消耗翻倍,其增长速度几乎是电网扩张速度的四倍。更重要的是,这种大规模数据中心建设潮的直接后果之一,便是可能推高周边地区的居民用电成本。